www.jagostat.com

www.jagostat.com

Website Belajar Matematika & Statistika

Website Belajar Matematika & Statistika

Cari artikel...

ANALISIS REGRESI

Analisis Regresi

Regresi Linear Sederhana

Regresi Linear Berganda

Analisis Regresi » Regresi Linear Sederhana › Metode OLS dalam Bentuk Matriks untuk Estimasi Model Regresi

Analisis Regresi

Metode OLS dalam Bentuk Matriks untuk Estimasi Model Regresi

Kita dapat menggunakan konsep matriks untuk menyatakan metode OLS. Ini berguna terutama ketika koefisien model regresi yang perlu diestimasi semakin banyak.

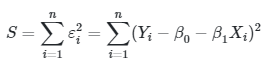

Anda mungkin masih ingat bahwa metode kuadrat terkecil digunakan untuk memperkirakan semua nilai koefisien regresi \(β\) (\(β_0\) dan \(β_1\) jika regresi linier sederhana dan \(β_0\) hingga \(β_k\) jika regresi linier berganda) sedemikian rupa sehingga meminimalkan kuadrat residual \((∑_\limits{i=1}^n ε_i^2)\). Misalkan \(S\) adalah kuadrat residual, maka dapat dituliskan

|

(1) |

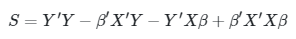

Kita dapat menyatakan persamaan \(S\) ini dalam bentuk matriks yakni

Dengan memperluas persamaan di atas, kita peroleh:

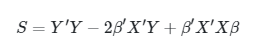

Karena \((Xβ)'=β'X'\) dan \(Y' Xβ\) adalah berukuran 1 x 1 (karena sama dengan transpose-nya, yaitu \(β' X' Y\)); kita peroleh

Untuk meminimalkan \(S\), maka kita menurunkannya terhadap \(β\) (atau terhadap \(β_0\) dan \(β_1\)). Sehingga

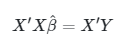

Dengan menyamakan hasil turunan ini dengan nol, dan dibagi dengan 2, dan mensubstitusikan nilai \(\hat{β}\) untuk \(β\) memberikan matriks dari persamaan normal kuadrat terkecil yaitu

di mana, \(\hat{β}\) merupakan vektor dari koefisien regresi kuadrat terkecil:

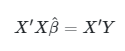

Untuk memperoleh taksiran koefisien regresi dari persamaan normal

kita mengalikan kedua sisi dengan invers dari \(X'X\), yakni

Kita tahu bahwa \((X'X)^{-1} X'X = I \) dan \( I \hat{β} = \hat{β} \). Dengan demikian, kita peroleh

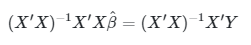

Sekarang perhatikanlah beberapa perkalian matriks yang bermanfaat berikut. Kita akan menggunakan ini untuk mendapatkan taksiran untuk \(β\).

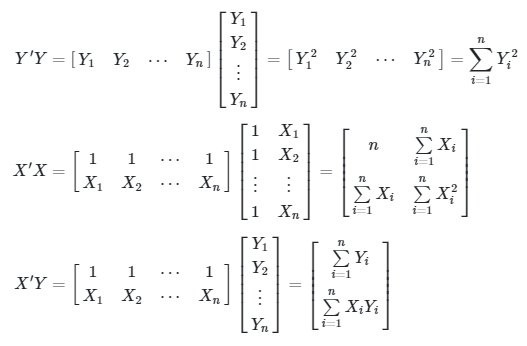

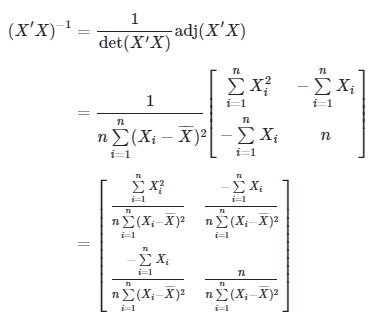

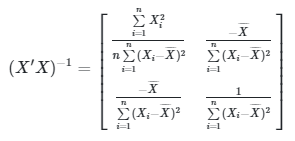

Berikutnya kita perlu mencari \( (X'X)^{-1} \). Tapi sebelum itu, kita hitung determinan \(X’X\), yakni

Dengan demikian, kita peroleh

Karena \(∑ X_i = n \overline{X} \), maka dapat disederhanakan menjadi

Artikel Terkait

The best and most beautiful things in the world cannot be seen or even touched. They must be felt with the heart.

Helen Keller